Kampfjets, die von KI geflogen werden, die größte Veränderung seit PageRank, geheime Google-Dokumente und ein Denkanstoß, den jeder sofort für sich und seine Kunden umsetzen kann. Die SMX Advanced bringt alles mit, was man sich von einer “advanced” SEO Konferenz wünscht.

Am 13. und 14.09.2023 fand die SMX Advanced in Berlin statt. Der Veranstalter hat in den Konferenzsaal des Pullmann Berlin Schweizerhof geladen und lockte mit einer hochkarätigen Besetzung der Speakertracks. Ich war zu Gast im SEO-Track und möchte Euch meine wichtigsten Takeaways mitgeben. Jeweils sechs Sessions an zwei Tagen.

Keynote: André Morys

André eröffnete die SMX Advanced und hatte ein wenig zu tun, das Publikum zu Interaktion zu bewegen. Das lag allerdings nicht am Inhalt seiner Session, sondern eher an der generell etwas zurückhaltenden Stimmung im interaktionsscheuen Stimmung im Publikum.

Unter dem Titel “Adapt or Die” führte er uns durch die Welt der zwei Zentralen Unternehmenstypen, die es seiner Ansicht nach auf dieser Welt gibt:

- die “Non-Digital-Natives” – Unternehmen, die ihre Wurzeln im Offline Business haben und

- die DIgital Natives

Für Non-Digital Natives galt seit jeher das Prinzip, erfolgreich ist, wer die richtigen Entscheidungen trifft und zwar öfter als sein Wettbewerb. Dazu bedurfte es entsprechen erfahrenen und herausragend gutem Personal, oder einer erfahrenen oder herausragend guten Beratung. Beides basiert laut Morys auf dem Glaubenssatz “Ich weiß , wie es am besten funktioniert”.

Bei Digital Natives hingegen habe sich der Ansatz etabliert ein “Growth Mindset” zu entwickeln. Was per se nichts mit Growth-Hacking oder ähnlichen Buzzwords zu tun hat, sondern mit dem Glaubenssatz, dass Wissenschaft besser ist als Glaube.

Digital Natives haben mit ihrem Growth Mindset gegenüber den Non DIgital Natives einen entscheidenden Wettbewerbsvorteil: sie testen mittels zahlreicher und häufiger Experimente, welche Entscheidungen ihr Business positiv beeinflussen und treffen auf Basis dieser Experimente dann ihre Entscheidungen. So treffen sie im Gegensatz zu den “Besserweissern” aus der Offlinewelt shchnellere und bessere Entscheidungen und erhalten so einen deutlichen Vorsprung gegenüber ihren Wettbewerbern.

Als Beispiele für Unternehmen mit einem solchen Growth Mindset nannte André unter anderem Tesla und booking.com. Letztere hätten regelmäßig um die 1.000 parallel laufende Experimente auf ihrer Website und schufen sich so einen Erkenntnisreichtum, der ihre Wettbewerber schlichtweg alt aussehen lässt.

Belegen konnte er diesen Vorteil mit dem enormen Wachstum von Booking.com im Vergleich zum deutlichen Rückgang des Amrktanteils ihres Wettbewerbers HRS.

Ziel der Experimente sei eines: Out-care the competition.

Die Experimente prüfen kundenzentrierte Hypothesen, die, wenn sie belegt wurden, schnell adaptiert oder bei Widerlegung verworfen werden können. Dabei kommt es gar nicht darauf an, ausschließlich positive Ergebnisse zu erzielen, in der Regel seien nur 10% aller Tests überhaupt positiv. Das genüge aber, um a) Verbesserungen zu erreichen und b) mit den negativen Ergebnissen die unpassenden Maßnahmen zu verwerfen oder entsprechende Entscheidungen rückgängig zu machen. Unternehmen die nach dieser “Insights Driven”-Methiode vorgehen, erfahren laut Forrester ein 10fach stärkeres Wachstum, als ihre klassisch ausgerichteten Wettbewerber.

Als Paradebeispiel für das Lernen aus fehlgeschlagenen Experimenten nannte André Amazon. Jeff Bezos habe mit” Amazon Auctions” und “Amazon Z Shops” große Produktideen getestet, die einfach gefloppt sind. Statt aufzugeben habe Bezos aber aus den Fehlschlägen gelernt und am Ende mit “Amazon marketplace” genau di erichige Entscheidung getroffen. “You can not fail. You only need to embrace failure to learn”

Tests und Experimente sind nichts neues. Unter den aktuellen Bedingungen stetig wachsenden Wettbewerbs und aufsteigender Digital Natives bleibt den Unternehmen mit klassischen Nin.-Digital Native Strategien nur eine Chance, um ihr Überleben zu sicher: das Growth Mindset zu etablieren. Dies gelinge am besten mit einer Top-Down Strategie, indem eine gemeinsame Vision und ein gemeinsamer Purpose für das Unternehmen gefunden und gelebt wird; dann können die meisten internen Hürden die einer Neuausrichtung im Wege stehen leichter überwunden werden.

Die wichtigsten Punkte, die jeder Teilnehmer in sein Unternehmentragen kann sind:

- es gibt keinen Zwang immer richtig zu liegen

- wer testet, spart Zeit und Energie, die sonst für Diskussionen und Abwägungen oder Rangkämpfe draufgeht

- man kann nicht verlieren, nur gewinnen (nämlich wichtiges Wissen)

Nach der aufweckenden Keynote wurde der große Konferenzsaal in zwei kleinere Säle aufgeteilt, in denen auf der einen Seite der PPC-Track, auf der anderen der SEO-Track stattfand. Ich habe meine Zeit ganz dem SEO-Track gewidmet

SEO Track Tag eins

Der erste Tag lässt sich thematisch in zwei Teile gliedern: KI und echtes Leben.Im ersten Teil des Tages führten Tom Anthony, Bastian Grimm und Lily Ray durch die neuen Möglichkeiten und Chancen, die KI mit sich bringt.

The Rise of AI, Bastian Grimm

Bastian brachte mit seinem Talk The Rise of AI: AI is “Everywhere”, But Now What!? eine schier überwältigende Flut an Beispielen von Tools, Möglichkeiten, Modellen, Risiken und Chancen, dass es kaum möglich ist, das alles auf Kerninformationen eindampfen. Was bleibt ist die Erkenntnis, dass momentan so viel los ist in diesem Themengebiet, dass man sich stark darauf fokussieren sollte, den tatsächlichen Nutzen für die eigene Arbeit und die eigenen Anforderungen zu erkennen und zu finden. Dabei ist es wichtig, die Funktion der Modelle und Tools zu verstehen.

Neben den vielen Vorteilen und Erleichterungen, die KI und besonders generative KI mit sich bringt, kommen auch enorme Risiken mit den Neuentwicklungen. Auch hier hat Bastian nicht geschwiegen, Versuche der U.S. Air Force, mit autonom fliegenden Kampfjets, die in der Lage sind, in den direkten Kampf gegeneinander zu gehen, seien als eines der für mich am bedrohlichsten scheinenden Beispiele genannt.Interessante Fortschritte, die Bastian nannte sind Metas “Humpback”, Toolformer , RecallM und RetNet.

Selbst lernende Modelle, Modelle, die sich den Gebrauch anderer Tools beibringen können und neue Architekturen, die die Möglichkeiten von Transformers weit in den Schatten stellen, werden noch deutlich mehr Anwendungsfälle nach sich ziehen. KI-Assistenten, die uns repetitive Arbeit – auch komplexere, mit Tools – abnehmen und uns Zeit schaffen für mehr strategische und kreativer Arbeit, lassen eine interessante und herausfordernde Weiterentwicklung der Tätigkeitsfelder im SEO warten. Schöne neue Welt.

Bastians Vortrag wäre der ideale erste in der Dreierreihe gewesen. Tom und Lily haben sich schon etwas genauer auf die tatsächlichen Möglichkeiten und Anwendungen konzentriert.

Entities are The Past, Tom Anthony

Tom hat mit einem eleganten Storrytelling, in dem er die aktuellen Entwicklungen und Auswirkungen von KI auf die Suche mit der denen der Entdeckung der Quantenphysik auf die allgemeine Physik verglich, eine bahnbrechende Veränderung prognostiziert.

Das Erkennen, Verarbeiten und Speichern von kontextuellen Informationen wird sich stark verändern. Wo momentan noch strukturierte Daten als stark beschränktes Input für die Beschreibung und Charakterisierung von Entitäten dienen, werden die sogenannten Latent Spaces, mit denen Large Language Models (LLM) Zusammenhänge erfassen und ontextuelle Informationen speichern, zu nahezu grenzenlosen Mögliochkeiten führen um ebendiese Informationen zu erfassen und für die Suche zu nutzen.

Als Beispiel führte Tom an, dass es momentan nicht möglich ist, ein Produkt, wie einen Kinderpool mittels schema.org als “kinderfreundlich” zu labeln- diese Informationsnuance existiert im Vokabular schlichtweg nicht. Ein LLM ist jedoch problemlos in der Lage aus der Produktbeschreibung “The swimming pool, surrounded by a lockable safety fence, has a depth of 2ft to 8ft.” zu schließen, dass er ein passendes Ergebnis für die Sucheanfrage “toddler friendly pool” ist. So illustriert er, dass LLM nahezu jedes Attribut und Verhältnis von Entitäten erfassen können. Schema.org und ähnliche Ansätze sind deutlich stärker begrenzt.

LLM eröffnen damit die möglichkeit kotexbezogene Facetten zu generieren, die Suchen verfeinern können, so wie es Google inzwischen sogar mit den Pills über den Suchergebnissen tut, die eine weitere Suchfacette zu öffnen, die von der ursprünglichen Suche mitgemeint sein könnte.

Damit das gut funktioniert, ist es nicht mehr nötig, Produkte mit strukturierten Daten auszuzeichen um sie mit Kontextinformationen anzureichern, sondern – da staunt der erfahrene SEO – z.B. Produktseiten mit kontextreichen Textinformationen auszustatten. Die Rückkehr der optimierten Produkttexte. KI kann dabei jetzt schon helfen entsprechende Informationen zu finden – man fragt z.B. ChatGPT welche alternativen Suchanfragen eine Person nutzen könnte, die nach einem “Ferienhaus mit flachem Pool” sucht. Die darauf gewonnenen Vorschläge können herangezogen werden, um das passende Ferienobjekt genauer und umfassender zu beschreiben.

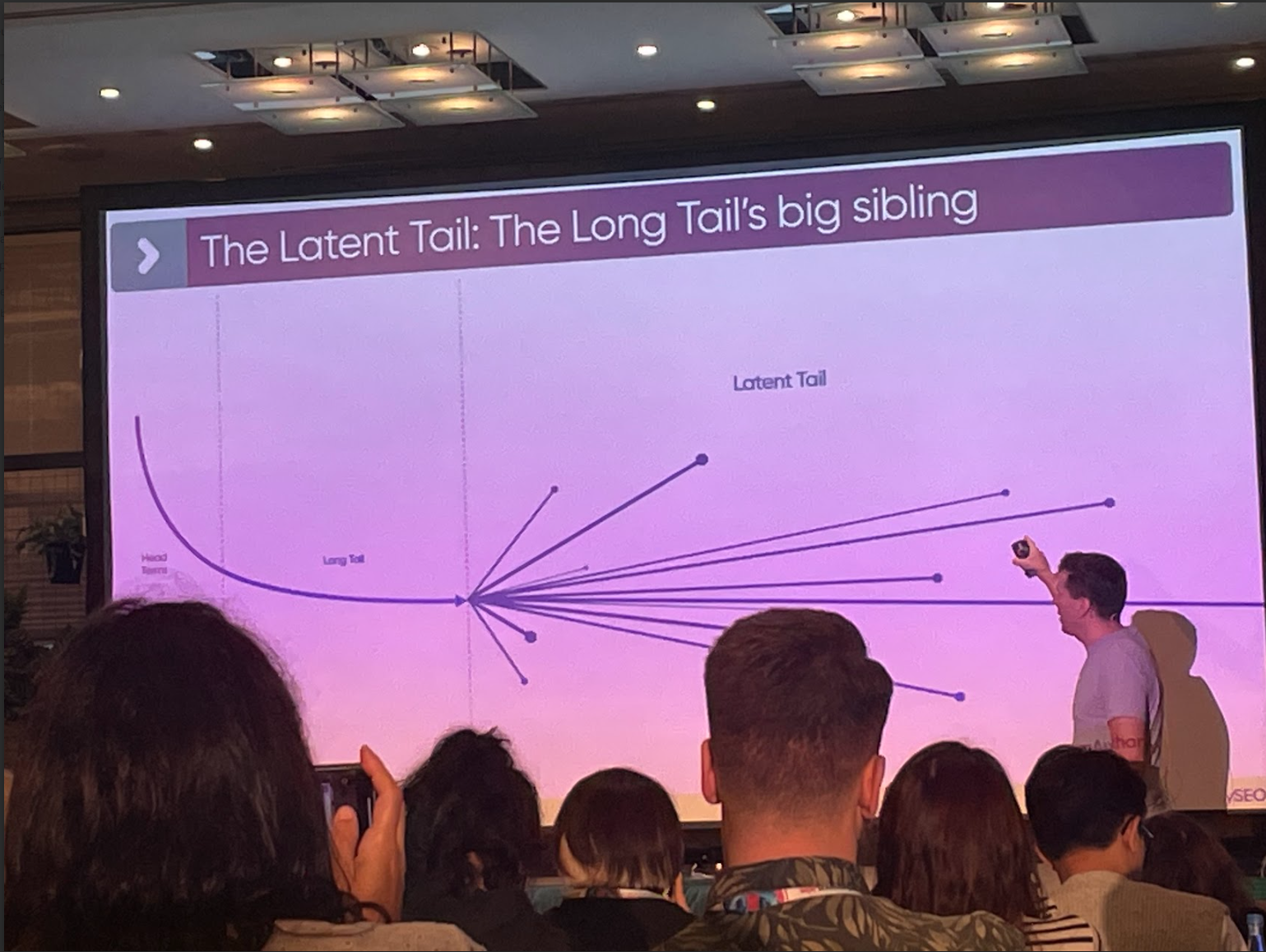

Aus dieser Fähigkeit entsteht etwas, was Tom den “Latent Tail” nennt. Eine Erweiterung des bekannten Keyword-Lomngtails, der Suchen enthält, die die ursprünglichen Suchbegriffe in verschiedene Richtungen erweitern oder verfeinern.

Die drastisch wachsende Fähigkeit, Kontext zu verstehen, sei, so Tom, die größte Veränderung in der Suche seit der Erfindung des PageRank.

Let’s Get Real: Advanced Tactics for Using AI Tools & Big Data Analysis to Improve E-E-A-T, Lily Ray

Lily präsentierte sehr interessante Ansätze, um die eigenen Inhalte und Webseiten auf Konformität mit verschiedenen Konzepten zu prüfen, die für eine gute Performance in der Googlesuche erfüllt sein müssen. Nach eine knappen und mit großartiger KI generierten Barbie-Stock-Fotos illustrierten Erklärung zur Funktion von LLM und deren Auswirkungen auf unseren SEO Alltag zeigte Lily ganz praktische Tricks:

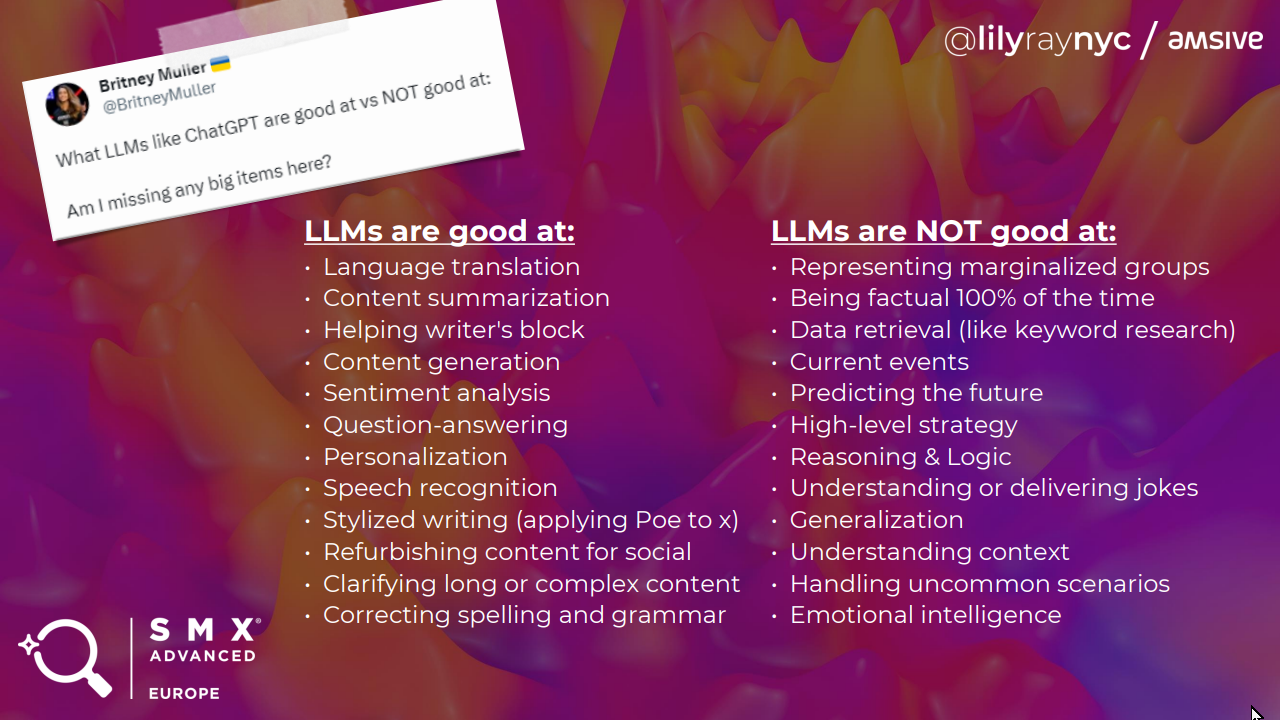

Wer KI für sich nutzbar machen möchte, muss dabei unbedingt darauf achten, der KI enge und klare Grenzen zu setzen, in denen sie sich bewegen darf, zum Beispiel durch Anforderungen aus einem Patent. Einfach so, nach User Intent zu fragen, oder etwa Suchvolumen erraten zu lassen ist ein erschütterndes No-Go, das lediglich von mangelndem Verständnis der Anwender zeugt.

Was können LLMs und was nicht?

LLM wie z.B. Claude können mit Google-Rictlinien oder Patenten gefüttert werden und danach mit der Aufgabe betraut werden, die eigene Webseite unter Berücksichtigung ebendieser Informationen zu bewerten. Die demonstrieren Ergebnisse waren erstaunlich. So ist Claude in der Lage Verbesserungsvorschläge zu machen, wie ein Artikel mehr Expertise und Authentizität vermitteln kann.

KI-Suchmaschinen wie Perplexity.ai können helfen, Belege und Quellen für eigene Aussagen zu finden, mit denen man dann wiederum die eigenen Inhalte aufwertet. Eine Form der Quellenrecherche, die so mancher Bachelor oder Masterarbeit bereichern könnte.

Wer seine Marke für die SGE stärken möchte, muss das System mit möglichst konsistenten kontextuellen Informationen zur Marke füttern. Eine neue Ära der Brand-Content-Pages und Profilseiten steht ins Haus. Als Beleg zeigte Lily ein beeindruckendes Experiment mit Informationen zu ihrer eigenen Person.

Roundtable Discussions

Die Roundtable-Discussions leiteten den thematischen zweiten Teil des Tages ein. In fünf losen Runden konnten sich die Teilnehmenden mit einem der vorangegangenen Speaker zu einem vorgegebenen Thema ins Gespräch gehen, eigene Fragen klären oder Impulse austauschen. Ich nahm an der thematisch offenen Runde mit dem Moderator des SEO-Tracks Dominik Schwarz teil.

In einer bunten Runde sprachen wir nach einer kurzen Vorstellungsrunde reale Herausforderungen und Probleme aus dem SEO Alltag einiger Teilnehmer.innen durch. Das war eine sehr willkommene realitätsnahe Abwechslung, nach dem großen KI-Block, der trotz aller Praxisbeispiele immer ein wenig fern der eigenen Lebensrealität blieb. Am Ende der Diskussion blieben die Erkenntnisse – wir haben alle dieselben Kämpfe zu kämpfen und: Diese Form des Austauschs sollte es öfter geben. Leider gab es an Tag zwei keine derartige Session.

Finding KPI that matter for your business, Alexander Breitenbach

Frisch geerdet und ins daily-SEO-Business zurückgeholt, konnte ich mir von Alexander ein paar praktische Tipps zur Identifikation und Überprüfung von KPI holen. Geschickt nutzte Alexander Beispiele aus der Psychologie, um verschiedene Fehlannahmen rund um KPI zu demonstrieren.

So nennt er den Survivorship Bias (https://de.wikipedia.org/wiki/Survivorship_Bias) als Problem bei der Betrachtung von KPI. Wer sich ausschließlich auf Erfolge konzentriert, verpasst wahrscheinlich wichtige Informationen, die es zu nutzen gilt. Daher lautet sein klarer Tipp, beispielsweise nach Google Updates nicht nur die Gewinner zu betrachten und zu prüfen, was sie gut machen.

Einige Statistiken sind in der Realität deutlich weniger belastbar, als erwartet. Hier führt Alexander die Broken Window Theory ins Feld, die sich schnell etablierte und auch heute noch als quasi gesetzt gilt. Tatsächlich beruhte die Theorie auf einer sehr begrenzten und unvollständigen Datenbasis, sodass sie bei genauerem Nachprüfen gehörig unter Druck gerät. Das sollte unseren KPI und ihren zugrundeliegenden Annahmen nicht passieren.

Um gute KPI zu finden, sollte man sie immer gegen die Business-Goals challanengen – hier schloss sich interessanterweise der Kreis zu Andrés Keynote am Morgen, in der bereits die Erkenntnis zutage trat, dass die Conversion Rate nur selten eine gute belastbare KPI ist. Besonders wenn man als Unternehmen vom Umsatz abhängt, können weniger Conversions absolut unproblematisch sein, wenn der dadurch entstandene Umsatz stimmt.

Die wichtigsten Punkte im KPI Design sind laut Alexander folgende:

- keine KPI ohne zugrundeliegende Strategie

- KPI müssen immer den Impact auf Business Goals zeigen können

- identifiziert stets Gegen-Metriken, die zeigen können wenn eine KPI nicht funktioniert

- passt KPI an die Stakeholder an, die sie reportet bekommen

- keine KPI ist in Stein gehauen – stellt sie regelmäßig auf den Prüfstand

Is there such thing as too much crawling? Jost de Valk

Jost schloss den ersten Tag mit einem Plädoyer für den Umweltschutz und der Verantwortung, die auch SEOs dafür tragen. Im Kern zeigte er, wie durch unnötige Bot-Hits und Crawls überflüssige Emissionen entstehen, die jeder Websitebetreiber einfach vermeiden kann.

Mithilfe von Logfiles lassen sich viele Ressourcen und URLs finden, die aufgerufen, aber nicht gebraucht werden. Hier gilt es anzusetzen und a) die Produktion der Ressourcen zu begrenzen und b) die Zugriffe von Bots zu beschränken. So ist es für wenige Webseiten wichtig, ob Baidu oder Seznam ihre Inhalte crawlen können. AuUch der ahrefs-Crawler, der sich besonders eifrig und requestfreudig zeigt, kann von vielen Seiten ausgeschlossen werden.

Hinzu kommen Potenziale, durch kürzere Ladezeiten Emissionen zu senken

Besonders vor dem Hintergrund der kommenden Verpflichtung zum CO2-Report für Unternehmen stellt dieses Thema eine ernstzunehmende Baustelle dar, der sich jeder SEO in seinem beruflichen Alltag widmen sollte. Ein kleiner, aber wichtiger Hinweis aus seinem Vortrag schien mir besonders wichtig: Google berücksichtigt die “last modified” Angabe in Sitemaps (wieder) – wenn sie korrekt genutzt wird.

SEO Track Tag 2

Technical SEO Audit – The Definitive Guide, Martin Splitt

Der zweite Tag wurde von Martin Splitt eröffnet. Der Google Developer Advocate machte es sich zur Aufgabe, uns die Kernfragen und Vorgehensweisen bei einem technischen SEO Audit nahezubringen.

Dabei startete er direkt mit einem der wichtigsten Punkte: “Ein guter technischer SEO Audit ist auf die Webseite zugeschnitten. Immer.” Reports aus Tools, die lediglich die Meldungen der Tools enthalten, sind kein sinnvoller Audit. Ziel sei es immer, Crawling & Indexing Hindernisse zu identifizieren.

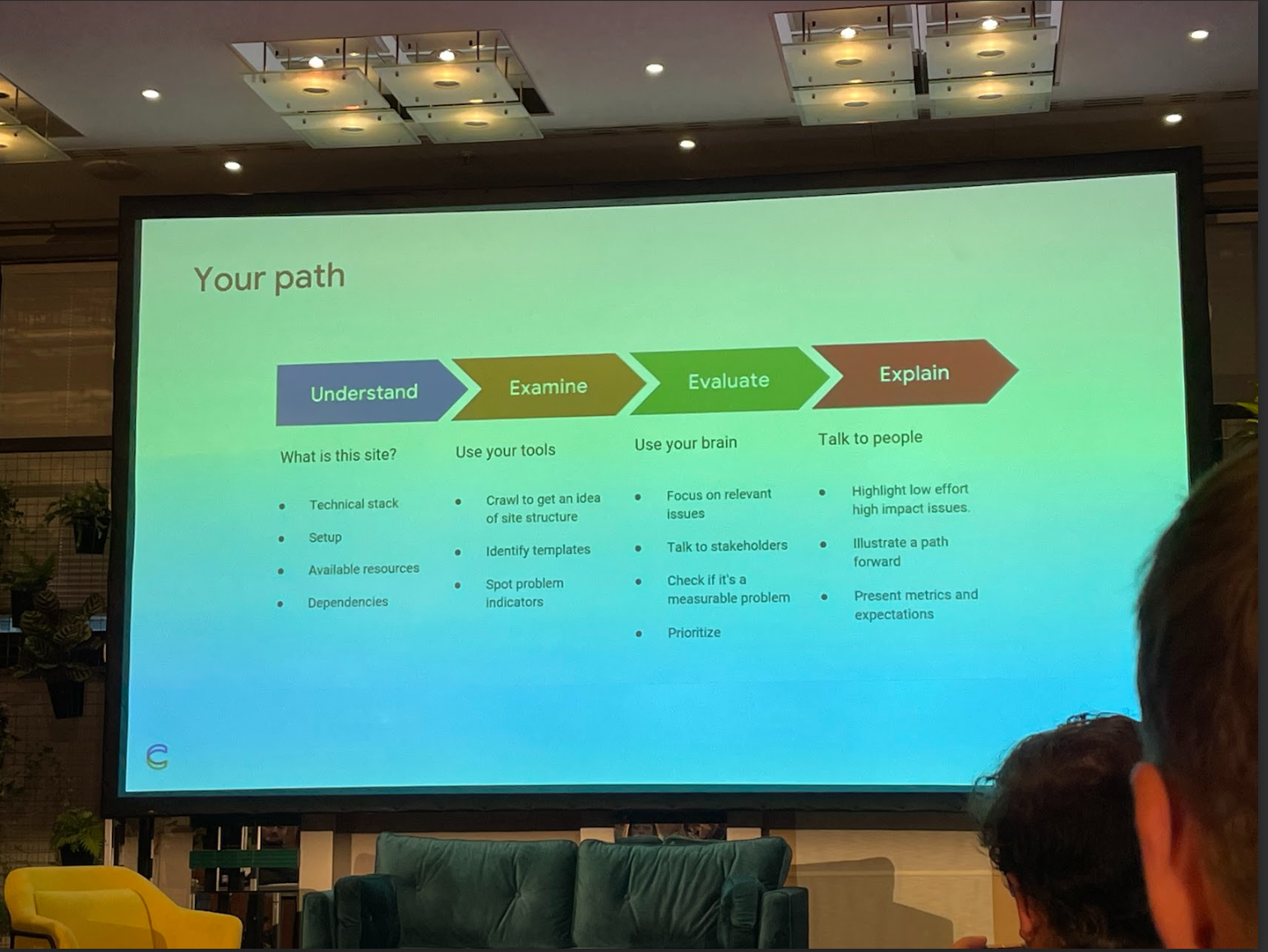

Er stellte den aus seiner Sicht idealen Prozess eines Audits dar, der sich in etwa so zusammenfassen lässt:

- verstehe die Seite: ihre Technologie, ihren Zweck, Abhängigkeiten und Ressourcen auf Kundenseite

- Sammle Daten (i.d.R. mit einem Tool/Crawler): identifiziere Templates und Problem-Indikatoren

- Evaluiere: “Use your brain!”, betrachte mögliche Probleme im Kontext der Seite (1.), sprich mit Stakeholdern darüber, konzentriere Dich auf tatsächlich relevante Probleme

- Erkläre: rede mit den umsetzenden Personen, fokussiere Low-Effort-High-Impact-Issues, konzentriere Dich auf Fortschritte und präsentiere relevante Metriken um Erfolge messbar zu machen

Martin wurde nicht müde immer und immerwieder darauf hinzuweisen, dass Tools nicht dazu da sind, um Probleme aufzudecken, sondern lediglich Hinweise geben können, wo etwas zu Problemen führen kann. Blindes Vertrauen auf Scores oder Fehlermeldungen ist ein Irrweg.

Beim Einsatz von Tools sollten deren Meldungen immer hinterfragt werden. Auch ist es unerlässlich, genau zu wissen, wie die Tools Scores ermitteln, oder zu ihren Meldungen kommen. Nur dann kann man beurteilen, ob die entdeckten Probleme tatsächlich reale Probleme sind.

Er brachte viele interessante und unterhaltsame Beispiele, wie Tool-Meldungen und Metriken einfach an der Realität vorbeigehen.

Zusammenfassend kann man den Vortag auf die altbekannte Aussage “A fool with a tool is still a fool” zusammen dampfen, garniert mit vielen interessanten Beispielen und einigen guten Tipps. Etwa fehlgeschlagene Netzwerkrequests per Traceroute nachzuverfolgen, um herauszufinden, welcher Server das eigentliche Problem verursacht, oder beim Rendering darauf zu achten, dass Browser fehlerhaften Code eigenmächtig korrigieren und so zum Beispiel bei fehlerhaften Elementen im <head>-Bereich dafür sorgen, dass nachfolgende Meta-Tags in den HTML-Body rücken.

Der direkte Austausch mit Entwicklern, die die betreffende Seite betreuen, ist unumgänglich, um Fehler beurteilen und mögliche Lösungen genau einschätzen zu können. Communication is key.

Visual Snippet Optimizatin – How To Stand Out From The Crowd, Markus Hövener

Markus hatte die undankbare Aufgabe, seine Session zu halten, während die bundesweiten Katastrophenalarm-Tests stattfanden. Trotz seiner vorherigen Bitte, die Telefone am besten abzuschalten, übernahmen gegen 11Uhr NINA und Katwarn die Session mit lautem und energischen Piepen und Tröten. Die Apps funktionieren zumindest zuverlässiger als beim letzten Test, das ist schon mal sicher.

Davon unberührt bleibt Markus hervorragender und problemlos 1:1 ins Leben übertragbare Vortrag. Er zeigte anhand vieler verschiedener Beispiele, wie man deutlich mehr aus den Text-Result-Images (https://developers.google.com/search/docs/appearance/visual-elements-gallery?hl=de#text-result-image) holen kann.

Im Kern ging es dabei um zwei Strategien:

- einzelne Bilder auf bestimmte Eigenschaften hin zu optimieren (Rabatte kommunizieren, USPs, etc. ins Zentrum der Grafiken zu rücken)

- eine einheitliche visuelle Identität aufzubauen, indem man eine kohärente Bildkomposition etabliert, die dafür sorgt, dass die eigenen Ergebnisse gut wiedererkennbar sind.

In der Regel bedient Google sich des ersten großformatigen Bildes auf der betreffenden Seite, um das Snippet anzureichern. Eine Auszeichnung eines speziellen gewünschten Bildes mit strukturierten Daten ist für Rich-Results möglich. Für “reguläre” organische Ergebnisse könne man auf das og:image Tag zurückgreifen, um Google dazu zu animieren, dieses Bild in den Suchergebnissen anzuzeigen.

Für Bilder, die in den organischen Ergebnissen angezeigt werden sollen, rät er zu 1:1-formatigen Bildern, die auch bei niedriger Skalierung gut erkennbar und ggf. lesbar sind. Idealerweise nutzt man keine Stock-Bilder. Besonders Shops können hier oft noch ordentlich etwas herausholen. Ein besonders gutes Beispiel hierfür wird in der Case Study von Brodie Clark erläutert.

Für Visual SERPs wie Google Discover ist es zu empfehlen, die Artikelbilder klug auszuwählen, um die Klickattraktivität zu steigern. Rezepte und Events sollte ebenso schlau bebildert werden, damit in den Suchergebnissen kein “Unfug” zu sehen ist.

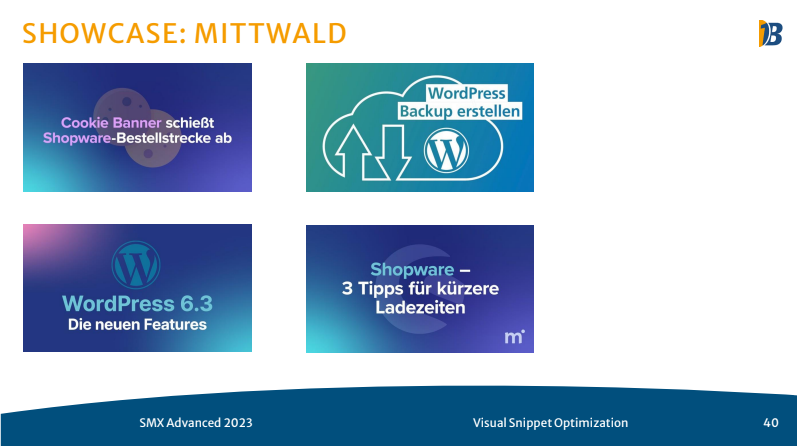

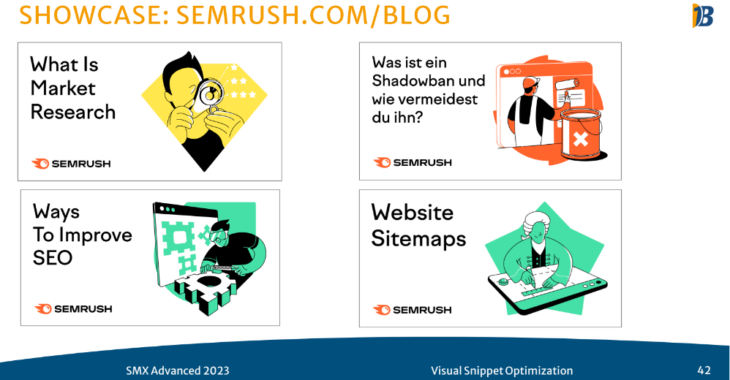

Zum Thema Visuelle-Identität rät Markus, sich vor allem von Youtubern inspirieren zu lassen. Diese sind seit langem gewohnt, schlau zusammengestellte und auf den Punkt pointierte Video-Thumbnails zu nutzen, um ihre Klickraten zu steigern. Marken, die schon gut mit ihren visuellen Identitäten arbeiten, sind Mittwald, Ahrefs oder Semrush – alle haben eine eigene gut erkennbare Bildskomposition entwickelt, die ihre Artikelbilder aus der Masse hervorstechen lassen.

Wichtig sei, das Format so zu wählen, dass die zentralen Elemente im Zentrum der Grafik stehen, damit sie sowohl auf Meta, als auch in den Google Ergebnissen gut aussehen. Meta verwendet 19:10 Bilder, die Google SGE hingegen 16:11. Eine catchy Headline und bedacht eingesetzte Illustrationen, die auch in kleinen Formaten gut erkennbar sind, sind die Zutaten für das Rezept zum perfekten Artikelbild.

Natürlich gab Markus auch direkt mit auf den Weg, wie man potenzielle Seiten identifiziert, bei denen man mit der Bild-Optimierung beginnen kann.

Ein Screaming Frog Crawl, bei dem das og:image Element per Custom Extraction erfasst wird und ein Segment für Seiten mit einem leeren/nicht vorhandenen og:image Element anlegt wird mit GSC Daten angereichert und “Tada” – los geht die Suche nach Seiten, die keine Bilder haben und damit welche bekommen sollten, oder Seiten, die unterdurchschnittliche Klickraten haben, bei denen mit einem besseren Bild nachgeholfen werden könnte. Hierbei noch der Hinweis, dass Sistrix es erlaubt in der Keyword-Tabelle nach Treffer-Merkmalen zu filtern: “Bild = ja” ist der Weg zu den eigenen Rankings mit Text-Result-Images.

Why We Need A Smarter Keyword Taxonomy (for localized searches), David Mihm

David zeigte einen umfassenden und sehr ausgefeilten Prozess, um die Relevanz verschiedener Suchbegriffe für lokale Unternehmen in lokalisierten Suchergebnissen zu bestimmen. Der Vortrag war so umfangreich und gespickt mit speziellen Einblicken, dass er kaum zusammenzufassen ist. Auch wenn das Thema und die Zielgruppe sehr nischig sind, sollte hier unbedingt ein Blick hineingeworfen werden.

Im Zentrum seines Vortrags stand auch die Schwierigkeit, dass SEO Tools akktuell kaum brauchbare Informationen für lokalisierte Suchergebnisse liefern. Wird ein Suchbegriff in Hamburg oder in Berlin gesucht, kann für Unternehmen, die entscheiden müssen, ob sie diesen Begiff targeten aktuell nirgends klar erkannt werden, ob es sich lohnt oder nicht. Die Ursache liegt laut David darin, dass die Tools durch die Bank weg mit Domain-basierten Scores und Wettbewerbsdaten auf Basis globaler Suchergebnisse arbeiten. Lokalisierte Suchergebnisse, die sich von Ort zu Ort sehr stark voneinander unterscheiden, werden nicht berücksichtigt. Als Beispiel führt er die Suche nach “Kniechirurg” in drei verschiedenen Städten ins Feld. Hier gibt es drei völlig unterschiedliche SERPS, aktuelle SEO Tools zollen dem aber keinen Tribut.

David zeigte, dass es sich lohnt, ein eigenes Verfahren aufzusetzen. Dabei berücksichtigte er die verschiednene Serps für Suchen in verschiedenen Orten – die Daten hierzu bekommt er von DataForSEO.

Unter anderem betrachtet er das auftreten verschiedener Domains in den verschiedenen SERPS um die Wettbewerbssituation zu berechen, er klassifiziert Domains nach Typ und Größe um SERPS auszusortieren, in denen local Businesses keine Chance haben und – Shortcut für jeden von uns – er bewertet die Chancen auf einer SERP danach, ob und wo ein Local Pack platziert ist. Steht das Local Pack am oberen Ende der SERP lautet der Weg das Google Business Profil zu optimieren. Steht das Local Pack am ende der Serp, oder fehlt ganz, ist die Webseite das geeignete Instrument um in den Wettbewerb zu treten.

Toolanbieter können einen interessanten Featurewunsch aus diesem Vortrag mitnehmen.

Der wahre Schatz neben dem Votrag ist, dass David seine Slides inklusive einer ausführlichen Appendix mit Formeln und Implemenrierungsanleitung, sowie ein Google-Sheet mit einem umfassenden Beispiel zur Verfügung stellt. Wer also wie David Kunden betreut, die vor der Entscheidung stehen, welche Suchbegriffe in welchen Orten für sie relevant und attraktiv sein können, findet hier einen sehr sehr hilfreichen Lösungsansatz für die Keywordrecherche: https://www.davidmihm.com/smxberlin

Für die programmatische Analyse von GBP-Kategorien und Services empfiehlt David übrigens Pleper.

How To Recover From An Unsuccessful SEO Relaunch By Activating Your Data, Christopher Gutknecht, Danny Zidaric

Danny und Christopher haben einen mutigen Schritt gewagt und keine Erfolgsstory sondern ein waschechten Fail vorgestellt. Sie präsentieren den massiven SIchtbarkeitseinbruch und Traffic-Rückgang bei Bergzeit nach einem erfolgten Wechsel des Shopsystems. Im Zuge der Relaunch-Arbeiten konnten SEO Anforderungen kaum oder nur teilweise umgesetzt werden, was am Ende fatale Folgen hatte.

Als Reaktion auf die entstandenen Verluste stellten Christopher und Danny ein ausgefeiltes Check- und Alerting-System auf die Beine, um großflächig die entstandenen Brandherde zu identifizieren und zu überwachen.

Die wichtigsten Punkte hierbei waren, dass sie nicht einfach nur Dashboards erstellt haben, sondern für jede Prüfung eine Benachrichtigung in den Teams-Chat eingerichtet haben. So konnte die Aufmerksamkeit aller Beteiligten zielgerichtet auf die Probleme gelenkt werden.

Zudem haben Christopher und Danny darauf verzichtet, neue Datentöpfe anzulegen, sondern haben ausschließlich bereits vorliegende Daten herangezogen: Analytics Daten, Sitemap.xml Daten, Logfiles. Die Pipelines und Alert-Konfigurationen haben die beiden bei GitHub zur Verfügung gestellt:

Die entdeckten Baustellen waren allesamt eher unspektakulär und treten in ihren Formen auf allen Systemen in verschiedenen Szenarien auf. Das Problem bestand daher zum Großteil an schwieriger oder mangelnder Kommunikation, auch weil SEO nicht nah genug am Produkt angesiedelt war. Und an der unzureichenden oder ganz fehlenden Implementierung der SEO Anforderungen.

Auch wenn erste positive Entwicklungen zu erkennen sind, bleibt noch einiges an Arbeit für die beiden offen. Dennoch war ihr Vortrag ein gutes Beispiel, um bei kommenden Relaunches, technologische Änderungen noch einmal zu überdenken und ggf. ein mögliches Fehlermonitoring bereits im Vorfeld zu etablieren. Nutzt die Daten, die Ihr schon habt, erstellt ein Monitoring und lasst Euch Alarmmeldungen schicken, sobald etwas merkwürdiges passiert.

How Google Works: What We Can Learn from Leaked Documents and Yandex, Johann v. Hülsen

Johann gab unter der strengen Beobachtung von Martin Splitt einige interessante Denkanstöße dazu, welche Probleme Suchmaschinen zu bewältigen haben und wie sie diese möglicherweise angehen. Sein Eröffnungsstatement, eine Suchmaschine zu bauen sei trivial, konnte er schon nach wenigen Minuten revidieren.

Als Quellen für seinen Votrag nutzte Johann Datenleaks, von denen der Yandex-Source-Code das wohl bekannteste der vergangenen Jahre war. Aber auch einen Google-Daten-Leak aus dem Jahr 2019, in dem vor allem auf die Möglichkeiten eingegangen wurde, Suchergebnisse nach dem Abruf aus dem Index erneut neu zu sortieren. Die Erkenntnis, dass der Rankingprozess mehrstufig abläuft und sich von Fall zu Fall unterschiedlich verhält lässt sich durch die Dokumentation sogenannter “Twiddler” nachvollziehen. Diese Programme sortieren vorliegende Suchergebnislisten je nach Kontext neu und sorgen so für deutlich volatilere Suchergennisse. Johann erklärt diese Unterschiede an den verschiedenen SERPS zu “co2” und “CO₂”.

Viele Aussagen sind nur spekulativ und inhaltlich nicht klar belegbar. Auch kommt hinzu, dass einige der besprochenen Funktionen der Suchmaschinen heute vielleicht ganz anders aussehen werden. Nichtsdestotrotz bieten Datenleaks von Suchmaschinen immer wieder einen interessanten Ansatzpunkt, um zu ergründen, wie Suchmaschinen funktionieren und Johann legt es jedem interessierten SEO nahe, sich an die Detektivarbeit zu machen. Gerade das Zusammenspiel zahlreicher verschiedener Systeme zeige zum einen die hochgradige Komplexität der Suchmaschinen – die sich nicht einfach nur an Überschriften oder Seitentiteln orientieren – zum anderen zeigen sie, welche Möglichkeiten es gibt, Veränderungen auf Suchergebnisseiten zu erklären oder zumindest erklärbar zu machen. Dazu kommen einige Kuriositäten, die sich besonders im Yandex-Quellcode finden lassen.

So gibt es einen Filter für zulässige Sprachen der Ergebnisse für Suchen aus der Türkei, oder einen starken Einbezug des persönlichen Browsingverhaltens, die jedoch nur marginales Gewicht erhalten.

Für alle, die sich an das Thema, wie eine Websuche gebaut werden kann, empfiehlt Johann den Search Off The Record Podcast , besonders die ersten 20 Folgen. Hört mal rein und lasst Euren Entdeckergeist wecken.

Dealing With User Intent in a Time Where Google Depends on AI, Jan-Willem Bobbink

Jan-Willem schloss die SMX Advanced mit einem weiteren Vortrag zur Anwendung von AI in die eigenen Arbeitsprozesse. Sein Ziel war es, den traditionellen Ansatz der Search-Intent auszuweiten und deutlich realistisches Set an Search-Intent-Kategorien zu erstellen. Die erste Idee, ein LLM den Search-Intent zu ermitteln verwar er direkt mit dem Hinweis auf die Funktion von LLM – diese können den Search-Intent lediglich “erraten”. EIne verlässliche Erkennung ist das aber nicht.

Jan-WIllem hat ein neues System entwickelt, um eben diese Erkennung der notwendigen Contentformate für eine Suchanfrage und die zugehörigen Suchergebnisse zu erleichtern. Sein Vorgehen lässt sich im Groben wie folgt zusammenfassen:

- erfasse die SERPs zu deinen Zielkeywords, Jan-Willem nutzt hierfür Valueserp.com und beobachtet die Top 5 URLs im 14 Tages-Zeitfenster

- Erfasse den Content der Top-URLs, hier ist der Tipp entweder mit der Python Library BeautifulSoup zu arbeiten, die einen einfachen Zugang zum Web Scraping bitet. Bei Seiten, die stark auf JavaScript setzen, oder Scraper blocken, sollte ein Blick auf selenium-stealth geworfen werden, Webservices wie ZenRows oder WebScraping API bieten ähnliche Service an und ersparen damit eigene Coding-Auwände

- der extrahierte Content wird dann durch ein LLM klassifiziert – Jan-Willem weist darauf hin, dass es sich für diesen Arbeitsschritt lohnt, ein lokales Modell zu fine tunen, da die genereischen Modelle noch oft daneben liegen was die Klassifikation angeht – Tipp GPT4All läuft Lokal und kann auf Webinhalte zugreifen und unter https://github.com/ gibt es einen klasse Vergleich, welches Modell sich besonders für welche Aufgaben eignet

- mit den Erkenntnissen der ersten Schritte lassen sich dann folgende Fragen beantworten:

- rankt die korrekte Seite aus meinem Asset?

- hat meine Zielseite den passenden richtigen Content im Vergleich mit dem Wettbewerb?

- welche Inhalte brauche ich, um auch in der SERP platziert zu werden?

Ein interessanter Nebeneffekt dieses Prozesses ist es, dass man automatisch den Wettbewerbscontent auf Veränderungen überwachen kann und so nachvollziehen kann, ob sich Änderungen positiv oder negativ ausgewirkt haben.

Die wichtigste Erkenntnis neben der noch vorhandenen Arbeitsintensität, die die LLM und WebScraping-Komponenten mit sich bringen lautet: Dieser kreative und umfangreiche Arbeitsansatz ist nur in seltenen Fällen wirklich notwendig.Es kann unter Umständen dazu führen, die SEO Strategie komplett zu ändern. Die meisten Kunden bedürfen aber selten einer solch ausgefuchsten Intent-NAalyse. Den vollständigen Prozess mit Tipps und Tricks bietet Jan-Willem hier an: https://notprovided.eu/intent

Fazit

Die SMX Advanced wird ihrem Namen mehr als gerecht, die Sessions waren durch die Bank weg sehr umfangreich auf hohem Niveau und gaben entweder massiv viele Über- und Einblicke oder sie waren extrem detailtief.

KI war ein wenig überpräsent, besonders am ersten Tag. Die tatsächlichen Anwendungsbeispiele inklusive ihrer Fallstricke zum Beispiel in den Vorträgen von Jan-Willem oder David waren aber sehr Lebensnah und erhellend.

Die nicht KI-basierten Sessions waren alle überzeugend sinnvoll und hilfreich und ich konnte aus jeder Session etwas für meinen Arbeitsalltag mitnehmen. Markus Hövener gebürt hier zweifach besonderes Lob: einmal für seine Beharrlichkeit, trotz der Warn-App-Alarme seinen Votrag unbeirrt durchzuziehen und viel wichtiger, für seinen unglaublich gut und schnell einsetzbaren Analyse- und Optimierungs-Tipp.

Besonderen Dank muss ich auch dem Moderatoren des SEO-Tracks aussprechen: Dominik Schwarz hat hier einen grandiosen Job gemacht. Er hat unaufgeregt moderiert, immer die richtigen Fragen gestellt und gekonnt nachgehakt, wenn etwas in den Vorträgen offen geblieben ist. Hier zeigt sich seine große fachliche Erfahrung und eine großartige Aufmerksamkeitsleistung.

Die Verpflegung war klasse – hier musste niemand fürchten, während der zwei Tage zu hungern. Mittagessen und Snacks waren lecker, ausreichend viel und für ein breites Publikum geeignet. Einzig der Networking-Space war etwas ungeschickt gewählt. Das Foyer des Hotels hat eine große Treppe im Zentrum, um die herum sich am Abend des ersten Tages alle Anwesenden scharten, hier kam schnell eine etwas gedrungene Atmosphäre auf.

Alles in allem, war das Event großartig und bereichernd, eine klare Empfehlung für den persönlichen Weiterbildungskatalog.

Jetzt Unterstützung in Online-Marketing erhalten